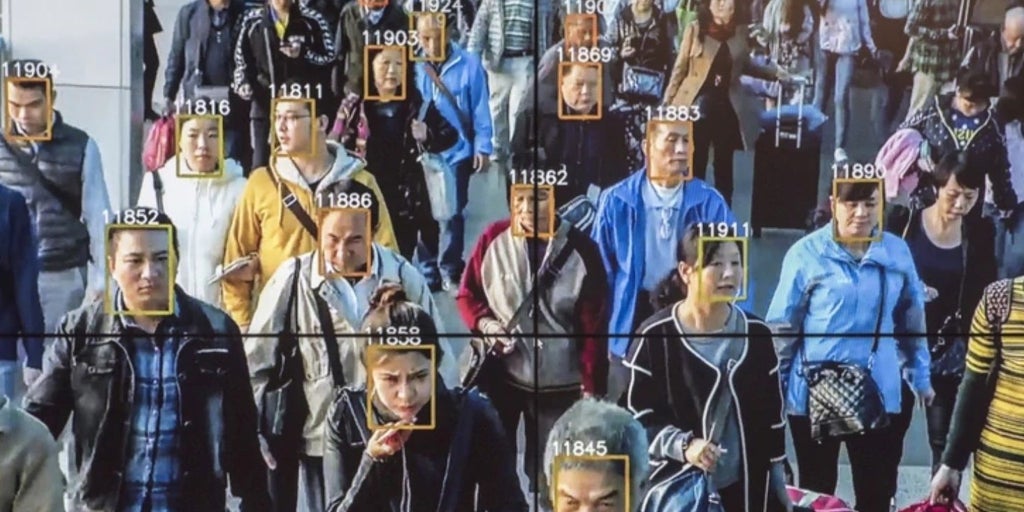

La inteligencia artificial no solo aprende de los datos, también hereda sus prejuicios. Durante años, los sistemas de reconocimiento facial y de análisis de imágenes se han entrenado con fotografías obtenidas de internet sin permiso, con escasa diversidad y sin control sobre su procedencia. … El resultado ha sido una cadena de algoritmos que reconocen peor los rostros de personas negras, mayores o con determinados rasgos físicos, y que perpetúan estereotipos culturales o de género.

Ahora, un equipo de Sony AI propone una alternativa radical: un conjunto de datos creado desde cero con criterios éticos. El trabajo, publicado en ‘Nature’ y liderado por la investigadora Alice Xiang, presenta el Fair Human-Centric Image Benchmark (FHIBE), el primer gran banco de imágenes humanas diseñado para evaluar los sesgos de los modelos de visión artificial de forma justa y transparente.

El FHIBE reúne fotografías de 1.981 personas de más de 80 países, todas obtenidas con su consentimiento y tras una remuneración económica por facilitar sus datos. Cada participante pudo retirar sus imágenes en cualquier momento, y los investigadores aplicaron técnicas de privacidad avanzadas para eliminar información personal o rostros de personas que no habían consentido su participación. «Queríamos demostrar que la ética puede incorporarse a cada etapa del proceso, desde la recogida de imágenes hasta su uso científico», explica Xiang a ABC. «Durante demasiado tiempo la investigación en inteligencia artificial ha dependido de bases de datos recopiladas sin consentimiento ni compensación, y eso tenía que cambiar».

La base de datos no es solo diversa geográficamente —con un 45% de imágenes procedentes de África y un 40% de Asia—, sino también en términos de edad, tono de piel, apariencia y condiciones ambientales. Cada imagen está acompañada de decenas de anotaciones: desde el tipo de luz o el modelo de cámara utilizado hasta 33 puntos anatómicos del rostro y el cuerpo. En total, más de 8.500 valores distintos de atributos, lo que la convierte en la colección de imágenes humanas más exhaustivamente etiquetada del mundo.

Los investigadores evaluaron tanto sistemas de reconocimiento facial, que buscan identificar a una persona entre miles —como los que utilizan las cámaras de seguridad o las redes sociales para sugerir etiquetas—, como de verificación facial, empleados en tareas de autenticación, por ejemplo, al desbloquear un móvil o en el control biométrico de los aeropuertos. Aunque ambos analizan rostros mediante redes neuronales, el primero implica una búsqueda entre muchos posibles y tiene mayores riesgos de vigilancia y discriminación, mientras que el segundo compara un rostro con una referencia concreta y tiende a fallar más con ciertos grupos, como las mujeres o las personas mayores.

Los resultados son reveladores: los algoritmos siguen mostrando notables diferencias de precisión según la edad, el color de piel o la ascendencia. En general, funcionan mejor con personas jóvenes, de piel clara y ascendencia asiática, y peor con personas mayores o africanas.

El análisis también permitió descubrir nuevas formas de sesgo que los estudios anteriores habían pasado por alto. Por ejemplo, los modelos de reconocimiento facial tienden a fallar más con hombres calvos porque asocian la ausencia de cabello con la pérdida de contorno facial, mientras que el pelo largo o cubierto por un pañuelo no genera el mismo problema. Los sistemas de verificación facial, en cambio, confundían más a las mujeres, «probablemente por la mayor variabilidad de peinados», dice el estudio.

El estudio destaca paradoja de que la propia comunidad científica, que denuncia los sesgos de la IA, siga dependiendo de bases de datos creadas sin permiso. FHIBE propone un nuevo estándar: una colección viva, que permite retirar imágenes si sus autores lo desean y que podría actualizarse con nuevas aportaciones. «Queremos que sea una herramienta de confianza para evaluar la equidad de los modelos», señalan sus autores.

Últimas Noticias

Source: www.abc.es